近日,腾讯云官网正式上线了腾讯混元A13B模型的API服务,输入价格定为每百万Tokens0.5元,输出价格则为每百万Tokens2元,这一举措迅速在开发者社区中引发了热烈反响。

作为业界首个13B级别的MoE(混合专家)开源混合推理模型,Hunyuan-A13B以其总参数80B、激活参数仅13B的精简设计,实现了与同等架构领先开源模型相媲美的效果,同时在推理速度上更胜一筹,性价比显著提升。这一创新不仅降低了开发者获取先进模型能力的门槛,更为AI应用的广泛普及奠定了坚实基础。

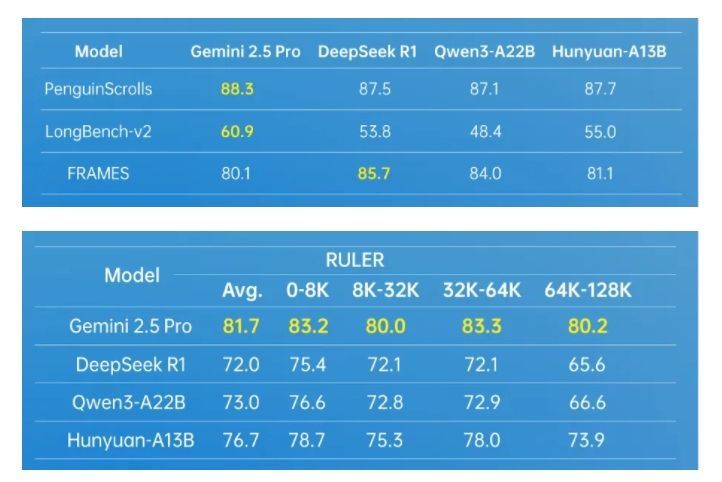

Hunyuan-A13B模型依托先进的架构设计,展现出了强大的通用能力。在多个业内权威数据测试集上,该模型均取得了优异成绩,尤其在Agent工具调用和长文处理方面表现突出。为了进一步提升Agent能力,腾讯混元团队还构建了一套多Agent数据合成框架,通过接入MCP、沙箱、大语言模型模拟等多样环境,并利用强化学习技术,让Agent在多种环境中自主探索与学习,从而显著提升了模型的实用性和效果。

在长文处理方面,Hunyuan-A13B支持256K原生上下文窗口,能够在多个长文数据集中保持优异表现。此外,该模型还创新性地引入了融合推理模式,允许用户根据任务需求在快思考和慢思考模式间自由切换,既保证了输出效率,又兼顾了特定任务的准确性,实现了计算资源的优化分配。

对于个人开发者而言,Hunyuan-A13B模型同样具有极高的友好度。在严格条件下,仅需1张中低端GPU卡即可完成部署。目前,该模型已无缝融入开源主流推理框架生态,支持多种量化格式,且在相同输入输出规模上,整体吞吐量是前沿开源模型的2倍以上,展现了其卓越的性能和灵活性。

Hunyuan-A13B模型的成功,离不开腾讯混元团队在模型预训练和后训练环节的创新技术。预训练阶段,团队训练了高达20T tokens的语料库,覆盖了多个领域,显著提升了模型的通用能力。同时,通过系统性分析和建模验证,团队还构建了适用于MoE架构的Scaling Law联合公式,为MoE架构设计提供了可量化的工程化指导。后训练阶段,则采用了多阶段训练方式,进一步提升了模型的推理能力和通用性。

作为腾讯内部应用和调用量最大的大语言模型之一,Hunyuan-A13B已广泛应用于400多个业务场景,日均请求量超过1.3亿次,充分证明了其在实际应用中的价值和稳定性。

https://cloud.tencent.com/product/tclm