微软今天凌晨在官网上开源了最新版本的 Phi-4家族模型 ——Phi-4-mini-flash-reasoning。这一新版本在继承了 Phi-4系列参数小、性能强的优点基础上,专为受到计算能力、内存和延迟限制的场景设计,能够在单个 GPU 上运行,非常适合笔记本和平板电脑等边缘设备。

Phi-4-mini-flash-reasoning 的推出,标志着推理效率的显著提升,相较于前一版本,推理效率暴涨了10倍,同时平均延迟降低了2到3倍。这种大幅度的性能提升,使其在高级数学推理方面表现得尤为突出,非常适合教育和科研领域的应用。

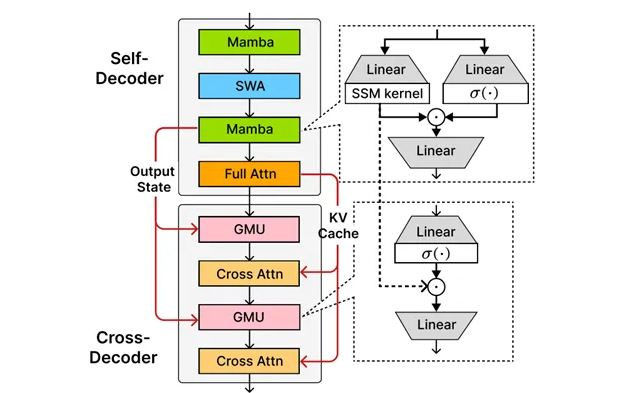

这一版本的核心在于微软自研的 SambaY 架构。SambaY 是一种创新的解码器混合架构,由微软与斯坦福大学共同研发。通过引入门控存储单元,SambaY 能够实现跨层的高效记忆共享,从而在提升解码效率的同时,保持线性预填充时间复杂度,增强长上下文性能,并且无需显式位置编码。

在长文本生成任务中,SambaY 展现了显著的效率提升。在处理2K 长度的提示和32K 长度的生成任务时,解码吞吐量相较于传统的 Phi-4-mini-Reasoning 模型提高了10倍。此外,在数学推理能力的测试中,SambaY 的表现也有显著提高,特别是在复杂的数学问题上,能够生成清晰且逻辑连贯的解题步骤。

微软还通过 Phonebook 和 RULER 等基准测试评估了 SambaY 在长上下文检索方面的表现。在32K 长度的上下文中,SambaY 在 Phonebook 任务中达到了78.13% 的准确率,表现远超其他模型。这证明了 SambaY 在长上下文理解与生成能力上的优势。

为了验证 SambaY 的可扩展性,微软进行了大规模的预训练实验,使用了3.8B 参数的 Phi-4-mini-Flash 模型,并在5T tokens 的数据集上进行了训练。尽管训练过程中遇到了一些挑战,但通过引入标签平滑和注意力 dropout 等技术,模型最终成功收敛,并在知识密集型任务中取得了显著的性能提升。

开源地址:https://huggingface.co/microsoft/Phi-4-mini-flash-reasoning

英伟达API:https://build.nvidia.com/microsoft

划重点:

🌟 微软推出 Phi-4-mini-flash-reasoning,推理效率提升10倍,适合笔记本运行。

🔍 创新 SambaY 架构通过高效记忆共享提升解码性能,适合长文本生成与数学推理。

📈 在基准测试中表现优异,Phonebook 任务准确率达78.13%,显示出强大的长上下文理解能力。

![[PS5] PlayStation Plus 15周年庆祝视频公开](http://www.klybb.com/wp-content/uploads/2025/07/144713pj0vkwtl505ahtkt-150x150.jpg)