近日,苹果公司与哥伦比亚大学的研究团队共同开发了一款名为 SceneScout 的人工智能原型系统。这一系统旨在为盲人及低视力群体(BLV)提供街景导航的辅助功能,帮助他们更好地进行日常出行。

SceneScout 系统通过结合苹果地图(Apple Maps)API 与多模态大语言模型(基于 GPT-4o 内核),生成个性化的环境描述。这一创新的技术使得用户能够获得更加直观和具体的导航信息,从而提升他们的出行体验。相关的研究论文已经在预印平台 arXiv 上发表,尽管尚未经过同行评审。

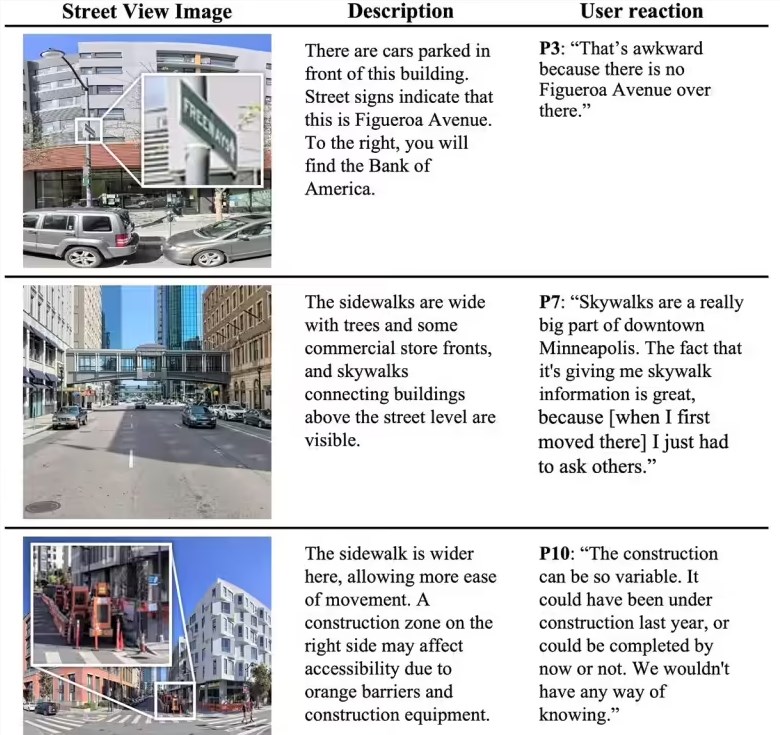

该系统的核心功能包括两大部分:首先是路线预览(Route Preview)。通过这一功能,用户能够预判行程中的道路状况,例如人行道的质量、交叉口的特征以及附近公交站的情况等。这些信息对于盲人用户而言,尤其重要,可以帮助他们在出行时提前了解周围环境。

其次是虚拟探索(Virtual Exploration)功能。该功能允许用户根据自己的需求进行开放场景的探索。例如,用户可以询问系统 “临近公园的安静居住区”,系统则会根据用户的需求提供相应的方向指引。SceneScout 通过模拟行人的视角解读可见内容,并生成结构化的文本信息,支持短、中、长不同格式的输出,能够适配多种读屏软件,方便盲人用户阅读。

在测试阶段,SceneScout 招募了10名视障用户进行使用,这些用户大多具有科技行业的背景。测试结果显示,72% 的 AI 生成描述被认为是准确的。而在虚拟探索模式中,用户反馈非常积极,称这一功能可以有效替代传统的信息获取方式,为他们的日常出行带来了极大的便利。

划重点:

🌍 苹果与哥伦比亚大学共同开发的 SceneScout 系统为盲人用户提供街景导航辅助。

📊 该系统结合 Apple Maps API 与多模态大语言模型,生成个性化环境描述。

👥 测试显示72% 的 AI 生成描述准确,虚拟探索功能受到用户高度评价。